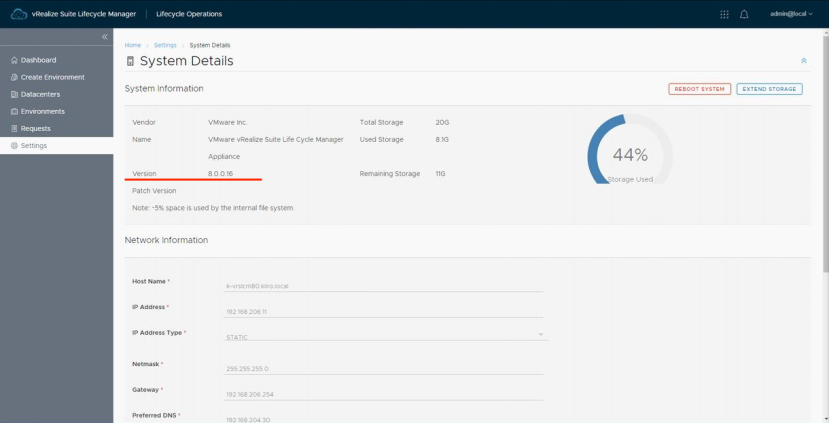

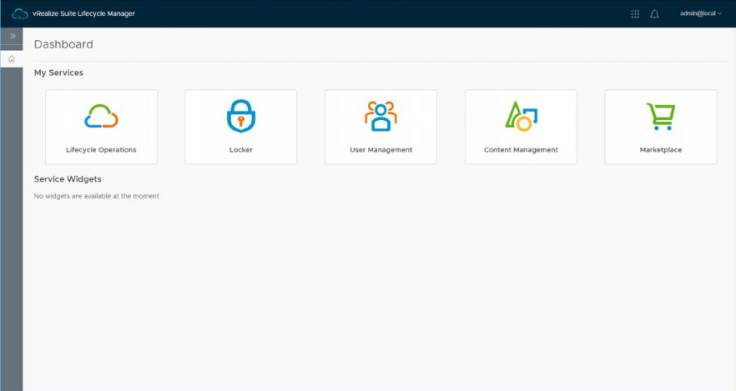

검증 환경에 vRealize Network Insight 5.1을 설치해서 이런저런 테스트를 하고 있습니다만 얼마 전 설치한 vRSLCM 8.0에 임포트 해서 관리를 하고 싶어 지더군요. (;・∀・) 그래서 vRNI를 임포트 하려 하니 vRSLCM 8.0를 8.1로 업그레이드해야 되더군요, 흐음... 그래서 vRSLCM 8.0를 업그레이드하기로 했습니다. 이번 포스팅은 이 버전업의 소개입니다. vRSLCM 업그레이드에 필요한 이미지 파일을 얻는 방법은 아래의 3가지 입니다. 온라인상에서 다운로드 이미지 파일의 다운로드 URL 지정 ISO 파일의 마운트 가장 간단한 방법은 My VMware를 통해 다운로드하는 것입니다만 운 좋게(?) 릴리스 된 vRealize Suite 제품을 전부 다운로드해뒀기 때문에 ..